人工智能应用于医疗保健 软件开发中的潜在风险与伦理警示

随着人工智能技术在医疗保健领域的深入应用,从辅助诊断、药物研发到个性化治疗方案设计,AI正以前所未有的速度重塑医疗体系。在蓬勃发展的背后,人工智能应用软件开发过程中潜藏的黑暗面不容忽视,这些风险可能对患者安全、医疗公平和隐私保护构成严峻挑战。

算法偏见是当前医疗AI开发中最突出的问题之一。由于训练数据多来自特定人群(如欧美发达国家、特定族裔或社会经济群体),导致AI模型在诊断和治疗建议上对少数群体、边缘社区或发展中国家的患者产生系统性偏差。例如,皮肤癌检测算法在深色皮肤人群中的准确率显著下降,心脏病预测模型对女性患者的误判率较高。这种偏见若未被及时发现和纠正,将加剧医疗不平等,使本已脆弱的群体面临更高风险。

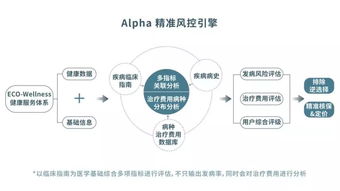

数据隐私与安全问题日益严峻。医疗AI的开发依赖于海量患者数据,包括基因信息、病史记录、影像资料等高度敏感内容。许多软件开发公司缺乏足够的数据安全防护措施,甚至存在数据滥用、非法交易或未经同意的商业化利用。近期多起医疗数据泄露事件表明,黑客攻击、内部人员违规操作或第三方合作漏洞都可能导致患者隐私大规模曝光,引发信任危机。

过度依赖AI可能导致临床判断能力退化。当医生习惯于接受算法推荐时,可能逐渐丧失独立分析和批判性思维的能力,尤其是在算法出现隐蔽错误或罕见病例超出模型训练范围时。更危险的是,一些AI系统以‘黑箱’方式运行,其决策逻辑难以解释,使医生无法验证建议的合理性,患者也难以理解治疗依据,违背了医疗透明原则。

商业化压力可能扭曲AI医疗开发的初衷。在资本驱动下,部分开发商急于将未充分验证的算法推向市场,夸大宣传效果,掩盖局限性。这种‘野蛮生长’不仅可能延误患者治疗,还可能引发医疗事故纠纷。专利垄断和高昂授权费用可能使先进AI医疗工具成为富裕地区的特权,进一步拉大全球医疗资源差距。

面对这些挑战,亟需建立多维度的治理框架:技术上,推动可解释AI、公平性算法检测工具的开发;法规上,完善医疗AI审批流程、数据使用伦理规范和事故问责机制;行业自律方面,鼓励开发商遵循‘患者利益优先’原则,公开算法局限性并接受独立审计。

人工智能在医疗保健领域的潜力巨大,但唯有正视其黑暗面,在软件开发阶段就嵌入伦理考量和风险控制,才能确保这项技术真正成为普惠、安全、可信的医疗革命力量。否则,我们可能在不经意间建造出一个看似高效、实则充满偏见与危险的数字医疗牢笼。

如若转载,请注明出处:http://www.jgaqjc.com/product/39.html

更新时间:2026-01-13 00:34:08